Что такое поисковый робот и зачем он нужен?

Поисковый робот (или краулер, паук, бот) — это специализированная программа, разработанная поисковыми системами (такими как Google, Яндекс, Bing и другими), для автоматического поиска, сканирования и индексирования страниц в интернете. Основная задача такого робота — исследовать веб-страницы, собирать и систематизировать информацию, чтобы поисковые системы могли сформировать релевантную выдачу по запросам пользователей.

Поисковые роботы помогают сайтам появиться в результатах поиска, обновляют уже существующую информацию и контролируют качество контента, предоставляемого пользователям.

Зачем нужны поисковые роботы?

Главные причины использования поисковых роботов следующие:

- Индексация контента. Роботы находят и фиксируют изменения на сайтах, обеспечивая актуальность данных в результатах поиска.

- Систематизация информации. Они классифицируют сайты и страницы по тематике, чтобы выдавать наиболее релевантные результаты по запросам пользователей.

- Поддержание качества выдачи. Роботы отсеивают низкокачественный и вредоносный контент, чтобы пользователи получали только безопасную и полезную информацию.

- Обеспечение быстрого доступа. Роботы постоянно проверяют доступность и скорость загрузки страниц, помогая поисковикам учитывать технические факторы в ранжировании.

Таким образом, поисковые роботы — это ключевые помощники поисковых систем, благодаря которым пользователи получают точную и полезную информацию в интернете, а владельцы сайтов имеют возможность эффективно привлекать аудиторию через поиск.

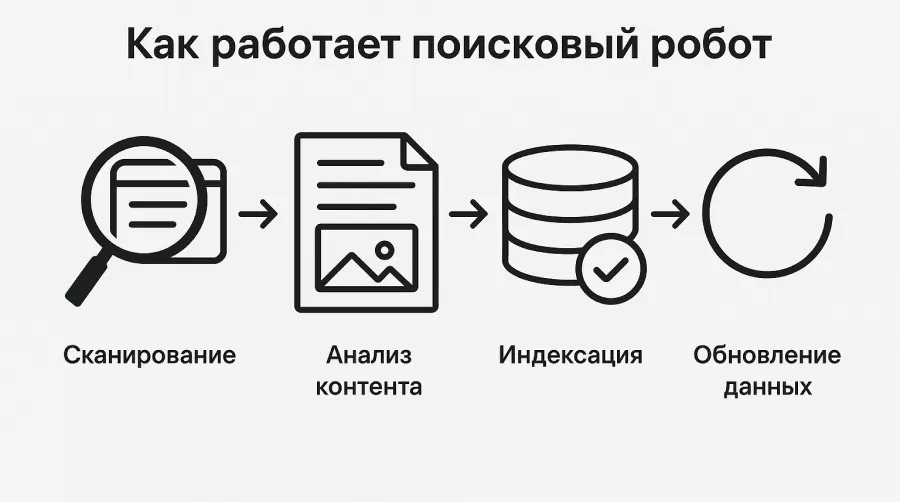

Как работает поисковый робот?

Процесс работы поискового робота состоит из нескольких последовательных шагов, которые обеспечивают эффективное сканирование и последующую индексацию страниц веб-сайтов.

1. Сканирование (Crawling)

На первом этапе робот следует по ссылкам, которые он находит на страницах, начиная с уже известных ему веб-адресов и постепенно переходя к новым ресурсам. Таким образом, робот перемещается по сети от страницы к странице, постоянно увеличивая свою «базу знаний» о существующих ресурсах в интернете.

2. Анализ контента (Parsing)

После того как робот обнаруживает новую страницу, он тщательно её анализирует:

- Определяет её текстовое и мультимедийное содержание.

- Проверяет заголовки, мета-теги и описания, которые помогают понять тематику страницы.

- Оценивает технические параметры (скорость загрузки, размер страницы и её элементы).

3. Индексация (Indexing)

На основе анализа контента поисковый робот отправляет полученную информацию в базу данных поисковой системы — это называется индексированием. После индексации страницы становятся доступными в поисковой выдаче по соответствующим запросам пользователей.

4. Обновление данных (Re-crawling)

Поисковые роботы регулярно посещают уже проиндексированные сайты для проверки на наличие изменений или обновлений контента. Если изменения найдены, робот повторно индексирует страницы, актуализируя данные в поисковой выдаче.

5. Ранжирование и отображение в поиске (Ranking)

Последний этап происходит уже на стороне поисковой системы, которая на основе собранных данных ранжирует страницы и формирует выдачу для пользователей, основываясь на различных факторах релевантности.

Таким образом, работа поискового робота представляет собой циклический процесс, обеспечивающий регулярное обновление информации в интернете и выдачу наиболее актуальных данных пользователям.

Виды поисковых роботов

Поисковые роботы можно разделить на несколько типов в зависимости от их функционала и задач, которые они выполняют. Рассмотрим основные из них.

| Вид робота | Назначение и функции | Примеры роботов |

|---|---|---|

| Основные (General Crawlers) | Индексирование веб-страниц и формирование поисковой выдачи | Googlebot, Yandex Bot, Bingbot, Applebot, DuckDuck Bot |

| Для изображений (Image Crawlers) | Индексация изображений, их поиск и отображение | Googlebot-Image, YandexImages |

| Для видеоконтента (Video Crawlers) | Индексация и поиск видеоконтента | Googlebot-Video, YandexVideo |

| Для мобильного контента (Mobile Crawlers) | Проверка оптимизации сайтов для мобильных устройств | Googlebot Smartphone, YandexMobileBot |

| Коммерческие SEO-роботы (SEO Crawlers) | Анализ сайтов, SEO-аудит и оптимизация | AhrefsBot, SemrushBot, Majestic, Screaming Frog, cognitiveSEO, OnCrawl |

| Социальные и новостные (Social and News Crawlers) | Индексация контента социальных сетей и новостных ресурсов | Facebook External Hit, Twitterbot, LinkedInBot |

| Спам-боты и вредоносные (Spam Crawlers) | Сбор данных, отправка спама, поиск уязвимостей и проведение атак | Различные анонимные и вредоносные боты |

Виды поисковых роботов

Сравнение поисковых роботов Google и Яндекс

Хотя Google и Яндекс являются лидерами среди поисковых систем, их роботы имеют свои особенности и алгоритмы работы. Рассмотрим основные различия и особенности:

1. Googlebot

- Акцент на скорость и мобильность:

Google активно продвигает концепцию Mobile First, уделяя особое внимание мобильной версии сайта. - Использование JavaScript:

Googlebot хорошо обрабатывает динамический контент, включая сайты, использующие современные JS-фреймворки (React, Vue, Angular и др.). - Частота посещений:

Зависит от популярности сайта, частоты обновления контента и технического состояния ресурса.

2. YandexBot

- Фокус на уникальный и качественный контент:

Яндекс тщательно отслеживает качество текстов, контентную уникальность и структуру сайта. - Региональная специфика:

Особое внимание уделяется региональной принадлежности сайта и географической привязке контента. - Ограниченная поддержка JavaScript:

Яндекс менее уверенно работает с динамическими сайтами, требуя дополнительных технических решений для корректной индексации.

| Параметр | Googlebot | YandexBot |

|---|---|---|

| Скорость индексации | Высокая | Средняя |

| Поддержка JavaScript | Высокая | Средняя (нужна предварительная генерация HTML) |

| Региональность | Умеренная (глобальная ориентация) | Высокая (ориентация на региональные особенности) |

| Влияние мобильной версии | Очень высокое | Среднее |

| Частота переобхода страниц | Зависит от авторитета и частоты обновления сайта | Зависит от контента и региона |

| Чувствительность к контенту | Высокая | Очень высокая |

Сравнение поисковых роботов Google и Яндекс

Как учесть различия при продвижении сайта?

- Убедитесь, что ваш сайт полностью адаптивен и оптимизирован под мобильные устройства (важно для Google).

- Создавайте уникальный, качественный контент, ориентированный на пользователей вашего региона (важно для Яндекс).

- Используйте простые технические решения для облегчения работы роботов: генерируйте статические версии страниц, если ваш сайт динамический.

Какие проблемы могут возникать при работе поисковых роботов?

Несмотря на очевидную полезность, в процессе работы поисковых роботов могут возникать некоторые сложности и проблемы:

1. Неполная или медленная индексация сайта

Иногда роботы не успевают полностью просканировать все страницы сайта, особенно если сайт новый, имеет сложную структуру или часто обновляется.

Причины:

- Сайт плохо оптимизирован.

- Отсутствие или ошибки в файлах robots.txt и sitemap.xml.

- Проблемы с сервером.

2. Повышенная нагрузка на сервер

Поисковые роботы отправляют большое количество запросов к сайту, что может приводить к перегрузке сервера, замедлению загрузки страниц или даже временному сбою работы сайта.

Причины:

- Роботы слишком часто заходят на сайт.

- Сервер не справляется с высокой нагрузкой.

- Отсутствует ограничение скорости обхода сайта роботами.

3. Индексация конфиденциальной информации

Иногда роботы могут случайно получить доступ к закрытой информации, такой как внутренние страницы, админ-панели или личные данные пользователей, если они недостаточно защищены.

Причины:

- Ошибки в настройках безопасности сайта.

- Неправильно составленный robots.txt или отсутствие тегов noindex/nofollow.

- Недостаточная защита личных и служебных данных.

4. Индексация нежелательного контента

Иногда роботы индексируют технические страницы, дубли или страницы с низким качеством, что может негативно сказаться на SEO-показателях сайта.

Причины:

- Отсутствие корректных настроек в файлах robots.txt и sitemap.xml.

- Наличие большого количества дублей или некачественного контента.

Эти проблемы могут серьезно повлиять на эффективность продвижения вашего сайта в поисковых системах, поэтому важно своевременно диагностировать и решать возникающие сложности.

Как повлиять на работу поисковых роботов

Чтобы эффективно контролировать работу поисковых роботов и добиться лучших результатов индексации сайта, используйте следующие рекомендации:

1. Правильно настройте файл robots.txt

Файл robots.txt помогает управлять доступом роботов к страницам сайта. Правильно настроив его, вы избежите индексации лишних или технических страниц.

Пример правильной настройки:

makefile

User-agent: *

Disallow: /admin/

Disallow: /private/

Allow: /

2. Используйте метатеги noindex и nofollow

Эти метатеги помогают исключать из индексации отдельные страницы или запретить роботам переходить по конкретным ссылкам.

- noindex — страницы не будут включены в поисковый индекс.

- nofollow — роботы не будут переходить по ссылкам.

Пример использования:

html

<meta name="robots" content="noindex, nofollow">

3. Регулярно обновляйте файл sitemap.xml

Sitemap.xml — это карта сайта, облегчающая работу поисковых роботов. Этот файл позволяет роботам быстрее обнаруживать новые и обновлённые страницы.

Отправляйте актуальный sitemap в Google Search Console и Яндекс.Вебмастер после каждого значительного обновления сайта.

4. Используйте инструменты для ускорения индексации

Специальные сервисы и инструменты помогают ускорить процесс обхода и индексирования страниц:

- Google Search Console: инструмент «Проверка URL».

- Яндекс.Вебмастер: функция «Переобход страниц».

5. Устраняйте технические ошибки сайта

Регулярно проверяйте сайт на ошибки (битые ссылки, ошибки сервера, некорректные редиректы). Устранение ошибок позволяет роботам беспрепятственно обходить сайт и индексировать страницы.

Используйте инструменты: Google Search Console, Яндекс.Вебмастер, Screaming Frog.

6. Ограничьте частоту обхода (Crawl Rate)

Если сайт испытывает повышенную нагрузку от обхода роботов, настройте частоту обхода:

- Google Search Console: в разделе «Настройки» → «Скорость сканирования».

- Яндекс.Вебмастер: «Настройки индексирования» → «Ограничение обхода».

7. Создавайте качественный и регулярно обновляемый контент

Роботы чаще посещают сайты с уникальным, качественным контентом, который регулярно обновляется. Это повышает авторитет ресурса и частоту его индексации.

Как узнать, что поисковый робот посещает сайт?

Убедиться в том, что поисковый робот регулярно посещает и сканирует ваш сайт, можно с помощью нескольких проверенных способов:

1. Анализ логов сервера

Логи сервера — это самый точный способ увидеть, кто и когда посещал ваш сайт, включая поисковых роботов.

Пример лог-записи посещения сайта роботом Google:

swift

66.249.66.1 - - [19/May/2025:12:34:56 +0300] "GET /page HTTP/1.1" 200 5320 "-" "Googlebot/2.1;

В логе можно увидеть:

- IP-адрес робота

- Дату и время посещения

- Страницу, которую он просканировал

- User-Agent робота

2. Сервисы аналитики (Google Analytics, Яндекс.Метрика)

Хотя стандартные отчеты сервисов аналитики часто не включают трафик от роботов, можно настроить специальные фильтры и отчеты для выявления посещений от поисковых ботов.

Например, в Яндекс.Метрике:

- Настроить отчёт "Роботы" в стандартных отчетах.

- С помощью фильтров выделить посещения роботов отдельно от обычных пользователей.

3. Инструменты для веб-мастеров

Сервисы Google Search Console и Яндекс.Вебмастер дают подробную информацию о действиях роботов на сайте:

Google Search Console:

- Отчет «Статистика сканирования»

- Список ошибок индексации и рекомендаций по их устранению

Яндекс.Вебмастер:

- Раздел «Обход роботом»

- Информация о посещениях, ошибках и рекомендациях

4. Сторонние сервисы мониторинга

Используйте SEO-сервисы (например, Screaming Frog, Ahrefs, Semrush), которые отслеживают активность поисковых роботов и дают информацию об их посещениях, статусах страниц и возможных проблемах.

Что делать, если робот редко посещает сайт?

Если вы заметили, что поисковый робот редко или вообще не посещает ваш сайт, это может говорить о проблемах. Проверьте следующее:

- Корректность файла robots.txt и meta-тегов robots.

- Доступность и скорость загрузки сайта.

- Наличие и актуальность файла sitemap.xml.

- Ошибки в Google Search Console и Яндекс.Вебмастере.

Используя эти методы, вы сможете точно понять, как часто и эффективно ваш сайт сканируют поисковые роботы, и своевременно реагировать на любые проблемы, связанные с индексацией.

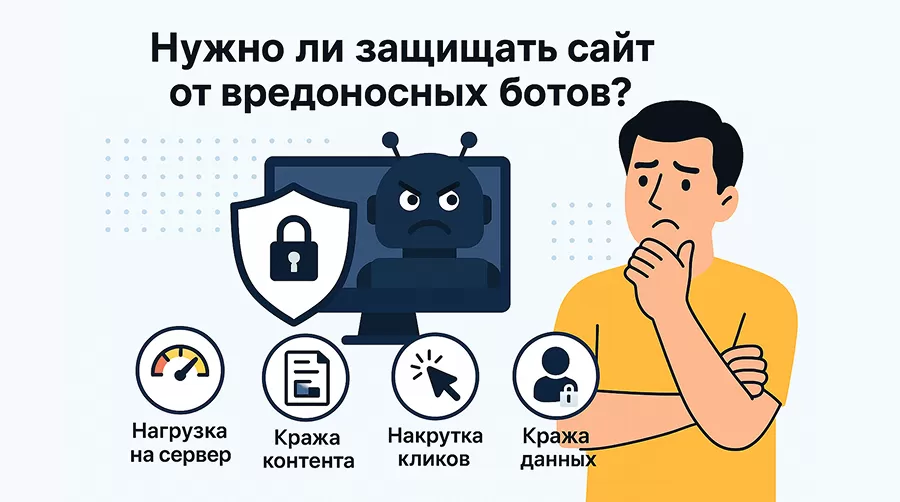

Нужно ли защищать сайт от вредоносных роботов?

В интернете существуют не только полезные поисковые роботы, которые помогают сайту попадать в результаты выдачи, но и вредоносные, которые могут нанести ощутимый ущерб ресурсу. Разберёмся, стоит ли защищать сайт от таких «плохих» ботов и какие методы можно применять для этого.

Почему нужно защищать сайт?

Вредоносные роботы могут создавать серьёзные проблемы:

- Повышенная нагрузка на сервер

Чрезмерная активность роботов-парсеров может привести к замедлению работы сайта, его сбоям или полной недоступности. - Кража контента (парсинг)

Вредоносные роботы могут копировать контент сайта и размещать его на других ресурсах, ухудшая уникальность материалов и снижая позиции в поиске. - Накрутка кликов и трафика

Злонамеренные боты могут искажать статистику посещений и взаимодействий, влияя на показатели эффективности рекламных кампаний и анализа аудитории. - Кража персональных данных

Неконтролируемые боты могут получать доступ к конфиденциальной информации пользователей и компании, что несёт юридические и репутационные риски.

Какие роботы считаются вредоносными?

| Тип робота | Описание проблемы | Примеры действий |

|---|---|---|

| Парсеры контента | Копируют текст и изображения сайта | Перепубликация контента на других сайтах |

| DDoS-боты | Создают нагрузку на сервер | Перегрузка сервера и недоступность сайта |

| Спам-боты | Оставляют спам в комментариях, формах | Засорение сайта и снижение доверия |

| Боты-накрутчики | Накручивают просмотры, клики и действия | Искажение аналитических данных |

Какие роботы считаются вредоносными?

Как защитить сайт от вредоносных роботов?

Для защиты сайта от вредоносных роботов используйте комплексные подходы:

1. Ограничение доступа с помощью robots.txt

Можно явно запретить доступ к ресурсам сайта определённым ботам, указав правила в файле robots.txt:

plaintext

User-agent: BadBot

Disallow: /

Однако это не самый эффективный способ для злонамеренных ботов, которые часто игнорируют такие указания.

2. Использование файла .htaccess (для Apache)

Для более эффективной блокировки нежелательных роботов используйте настройку .htaccess, блокируя доступ по IP или User-Agent:

apache

# блокировка по User-Agent

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} (BadBot|EvilBot|SpamBot) [NC]

RewriteRule .* - [F,L]

# блокировка по IP-адресу

deny from 192.168.1.1

3. Внедрение CAPTCHA

Добавляйте CAPTCHA для форм регистрации, комментариев и других форм, чтобы снизить вероятность автоматической активности роботов.

4. Настройка WAF (Web Application Firewall)

Используйте специализированные firewall-сервисы, такие как Cloudflare или Sucuri, которые способны отслеживать и блокировать вредоносный трафик.

5. Мониторинг и аналитика

Регулярно отслеживайте трафик и поведение пользователей с помощью инструментов веб-аналитики (Google Analytics, Яндекс Метрика). Необычное поведение пользователей может указывать на активность роботов.

Заключение

Поисковые роботы — это фундаментальный элемент работы современных поисковых систем. Именно они определяют, насколько быстро и полно ваш сайт появится в поисковой выдаче, найдут ли его ваши потенциальные клиенты и насколько эффективно будут работать SEO-стратегии.

Умение взаимодействовать с роботами, контролировать и направлять их работу — обязательный навык для владельцев сайтов и маркетологов. Это поможет ускорить индексацию страниц, защитить важную информацию и избежать негативных последствий от деятельности вредоносных ботов.

Если вы хотите узнать, насколько ваш сайт эффективно взаимодействует с поисковыми роботами, закажите профессиональный SEO-аудит у нашей команды специалистов. Мы поможем выявить и устранить все возможные проблемы, повысив позиции вашего сайта в поисковой выдаче.

А чтобы всегда быть в курсе новых тенденций и полезных рекомендаций в интернет-маркетинге и SEO-продвижении, подписывайтесь на наш Telegram-канал. Будьте в тренде, развивайте свой проект эффективно и грамотно!